相關研究論文已于近日發布在預印本服務器arXiv上,指出學者難以接觸到最先進的計算系統,這可能阻礙他們開發大型語言模型(LLM)和其他AI研究的進展。

(圖片來源:nature)

具體而言,學術研究者往往沒有資源獲取足夠強大的圖形處理器(GPU)——這些電腦芯片常用于訓練AI模型,且價格昂貴,可達數千美元。相比之下,大型科技公司的研究者預算更高,可以在GPU上投入更多資金。“每增加一塊GPU,就能提升更多算力。”美國布朗大學計算機科學家、該研究的合著者Apoorv Khandelwal表示,“雖然行業巨頭可能擁有數千塊GPU,但學者可能只有幾塊。”

“學術界與行業界的模型差距巨大,但本可以小得多。”美國華盛頓特區非營利AI研究機構EleutherAI的執行董事Stella Biderman說。她表示,對這一差距的研究“至關重要”。

為了評估學者可用的計算資源,研究團隊對35家機構的50名科學家進行了調查。受訪者中,66%對自己的算力滿意度打了3分及以下(滿分5分)。“他們根本不滿意。”Khandelwal說。

各大學在GPU訪問設置上有所不同。有些學校設有供各部門和學生共享的中央計算集群,研究人員可申請GPU使用時間。另一些機構可能為實驗室成員直接購買機器。

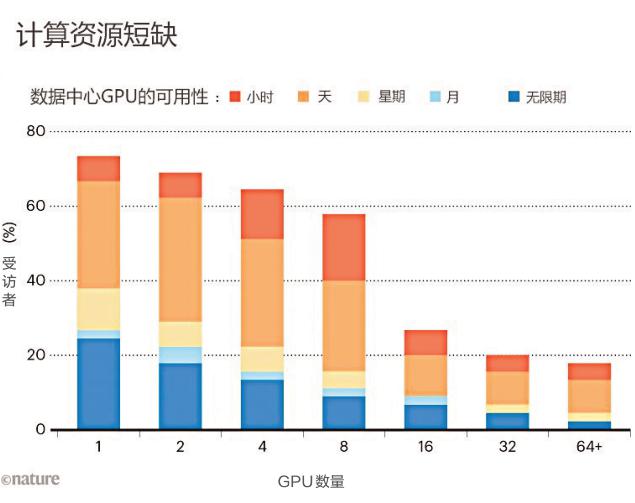

柱狀圖揭示了調查的結果:學者通常只能有限地訪問圖形處理器,這進而限制了他們訓練機器學習模型的能力。

一些科學家表示,他們不得不等待數天才能使用GPU,并指出在項目截止日期前后等待時間特別長。調查結果還凸顯了全球算力訪問的差異。例如,有受訪者提到在中東地區難以找到GPU。僅有10%的受訪者表示,他們可以使用英偉達的H100GPU,這是專為AI研究設計的高端芯片。

這一障礙極大地加劇了預訓練過程的難度,即向大型語言模型(LLM)輸入海量數據集的過程變得尤為困難。“由于成本高昂,大多數學者甚至不敢涉足預訓練領域的研究。”Khandelwal指出。他和同事堅信,學者在人工智能研究中帶來了獨一無二的視角,而算力的匱乏可能會嚴重制約這一領域的未來發展。

“為了長期的增長和技術發展,擁有一個健康、有競爭力的學術研究環境至關重要。”美國布朗大學計算機科學和語言學學者、該研究的合著者Ellie Pavlick說,“相比之下,在行業研究中往往存在顯著的商業壓力,這有時會促使研究人員急于求成,減少了對未知領域的探索。”

研究人員還深入探究了學者如何在算力資源有限的情況下更高效地進行利用。他們測算了在使用1至8塊GPU的低資源硬件環境下,預訓練多個大型語言模型(LLM)所需的時間。盡管面臨資源限制,學者仍成功訓練出多個模型,但這一過程耗時更長,并要求他們必須采用更為高效的方法。

“我們實際上可以延長現有GPU的使用時間,從而在一定程度上彌補與行業界的差距。”Khandelwal說。

“在有限的計算資源上竟然也能訓練出比許多人預期中更大的模型,這確實令人驚嘆。”德國薩爾布呂肯薩爾蘭大學神經顯式模型研究者Ji-Ung Lee表示。他進一步指出,未來的研究可以聚焦小公司行業研究者的經歷,因為他們同樣在計算資源獲取上面臨困境。“并非所有有能力獲取無限算力的人都能夠如愿以償。”他補充道。

關鍵詞:

凡注有"環球傳媒網"或電頭為"環球傳媒網"的稿件,均為環球傳媒網獨家版權所有,未經許可不得轉載或鏡像;授權轉載必須注明來源為"環球傳媒網",并保留"環球傳媒網"的電頭。